TE AYUDAMOS CON TODO LO RELACIONADO CON ALOJAMIENTO WEB

¿Estás comenzando a montar un proyecto digital? Busca el alojamiento web perfecto para ti

Si buscas un hosting económico para tu nuevo proyecto web, echa un vistazo a nuestros planes más competitivos, perfectos para comenzar tu negocio digital, con todas las garantías y un precio super potente.

Si vas a diseñar tu página en WordPress, te recomendamos apostar por un Hosting Wordpress, también puedes escoger un plan de Hosting Web y si necesitas más capacidad, escoge nuestro VPS barato, un servidor exclusivo para ti.

HOSTING WORDPRESS I

PARA COMENZAR EN WP

,99

€/mes

Registro de dominio gratis*

Soporte 24x7

5 cuentas de correo

Alojamiento de 1 Web

5 GB espacio SSD NVMe

WordPress instalado

HOSTING M

PERFECTO PARA COMENZAR

,00

€/mes

Registro de dominio gratis*

Soporte 24x7

10 GB espacio SSD NVMe

Alojamiento de 1 Web

20 Cuentas de correo

Tráfico ilimitado

VPS GO!

NUESTRO SERVIDOR MÁS BÁSICO

,50

€/mes

Procesador 2 cores

Soporte 24x7

20 GB espacio SSD NVMe

4 GB RAM

Panel de control Plesk

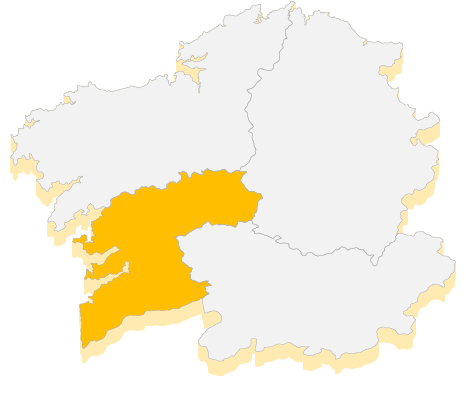

IP española